Diószegi-Horváth Nóra, Német Szilvi

Múlt hétvégén Karácsony Gergely főpolgármester csalás áldozata lett: videón beszélt valakivel, aki Vitalij Klicskónak, a kijevi főpolgármesternek adta ki magát. Az ál-Klicskótól, aki „pontosan úgy nézett ki és beszélt”, mint a valódi, több európai nagyváros, például Berlin, Madrid és Bécs vezetője is kapott hasonló hívást.

Karácsony Facebook-posztjából kiderült: a videóhívásra való megkeresés egy, a kijevi főpolgármester domainjét használó e-mail címről érkezett, és a hívás nagy részében az Ukrajna elleni háborúval és menekültválsággal kapcsolatos beszélgetés folyt, ám “a hívás végéhez közeledve több furcsa, gyanút keltően provokatív jellegű kérdés is elhangzott”, ami miatt Budapest főpolgármestere a tervezettnél jóval korábban befejezte a beszélgetést.

Karácsony jelezte továbbá:

„Minderről hivatalosan tájékoztatom a magyar titkosszolgálatokat felügyelő minisztert, és felkérem a Főpolgármesteri Kabinet Városdiplomáciai Csoportját, hogy az Ukrán Nagykövetséggel, a magyar nemzetbiztonsági szervekkel és a többi érintett európai nagyvárossal egyeztetett módon tárja fel a professzionális deepfake technológiát használó csalás részleteit.”

Főpolgármesteri Hivatal sajtóosztálya a Lakmusznak azt mondta, hogy technológiailag olyan profi módon működött a csalás, hogy a videóhívásban részt vevő ál-Klicskónak sem a kinézete, sem a beszéde nem adott okot a gyanakvásra. A Zoom-beszélgetés során nem volt érzékelhető, hogy egy hamis képmással zajlik az egyeztetés.

A főpolgármester esete is bizonyítja: mára a deepfake technológia nem csak fejlett, de lényegében már bármikor, bárkit elérhet.

A deepfake évek óta jelen van a mindennapjainkban (gondoljunk csak az arccserés appokra, amik egy időben hatalmas népszerűségnek örvendtek a különböző közösségi média-platformokon), és egy ideje tudjuk is, hogy nem pusztán a szórakoztatás a célja.

A Redditen már 2017-ben elindult egy olyan trend, amelyben pornószínésznők arcát cserélték celebekére. Az újítás annyi volt a korábbi, manipulált videókhoz képest, hogy nem a felhasználók, hanem a mesterséges intelligencia (AI) végezte a videókon a módosítást. Egyébként maga a deepfake elnevezés is a Redditnek köszönhető: a deep learning (mély tanulás) és a fake (ál-, hamis) szavak összemosásával jött létre.

Egy ideig úgy tűnt, hogy a pornó lesz a deepfake technológia kiteljesedésének terepe: 2019 szeptemberében egy kutatás rámutatott: abban az évben 9 hónap alatt mintegy 15 ezer deepfake videót detektáltak, amelyeket ez idő alatt 134 milliószor tekintettek meg. A videók 96 százaléka volt pornográf tartalom, 99 százalékuk női hírességek (köztük Scarlett Johansson és Gal Gadot színésznők, illetve Taylor Swift énekesnő) arcképét használta fel.

A DeepFakeLab videóján a webkamera előtt ülő modell (jobbra) Leonardo di Caprio arcát ölti magára. Forrás: YouTube

2020-ban továbbra is a pornótartalmak domináltak a deepfake technológiával készült videók közt, azonban mostanra már nemcsak hírességek, hanem “egyszeri” felhasználók is egyre gyakrabban válnak ennek a technológiának az áldozatává, a pornó mellett egyre több olyan terület van, ahová beférkőznek az ilyen típusú tartalmak.

Az egyik legismertebb eset az volt, amikor egy amerikai nő azt akarta elérni, hogy lánya társait kirúgják a cheerleader-csapatból. Deepfake videókat készített a csapattagokról, amelyeken meztelenül láthatóak, alkoholt és kábítószereket fogyasztanak.

De történt olyan is, amikor több százezer dollárt csaltak ki egy energetikai cég vezérigazgatójától telefonon úgy, hogy egy nemzetközi cég vezetőjének a hangját utánozták hangszintetizáló programmal, az Egyesül Arab Emirátusokban pedig hasonló módszerekkel 35 millió dollárt tulajdonítottak el egy cégtől.

Ha korábban könnyen ki lehetett szúrni a deepfake-eket arról, hogy a felvételen szereplő arc nem pislogott, addig ma már nincs ilyen könnyű dolgunk. Az újabb szoftverek az arcmozgást és a hangot is egyre élethűbben állítják elő, ezekből mutatunk most pár példát.

Egyetemi kutatók már 2016-ban bemutattak egy olyan arcfelismerő szoftvert (Face2Face), amely élőben képes egy videófelvételen szereplő arc mimikáit hozzáigazítani egy másik emberéhez, aki a webkamera előtt ül. Akkor a fejlesztők még csak azon gondolkodtak el, hogyan forradalmasíthatná ez a technológia a filmipart, a Face2Face alkalmazást mégis a világ vezető politikusainak – így Bush, Putyin, Trump és Obama – beszédein tesztelték.

Nem sokkal később készült el a FakeApp nevű alkalmazás is, amellyel már lényegében bárki készíthetett ilyen módon manipulált videókat, ha megvolt hozzá a megfelelő technikai háttere. A BuzzFeed akkoriban le is tesztelte ezt, olyan videót készítettek, amelyen látszólag a volt amerikai elnök, Barack Obama beszél a deepfake-ről:

A BuzzFeed jelezte: Obama erről a valóságban nem beszélt, a FakeAppnak 56 órára volt szüksége ahhoz, hogy a videót megalkossa.

Az orosz-ukrán háború a deepfake számára is új teret nyitott: készült már olyan manipulált videó, amelyen Zelenszkij ukrán elnök beszél a kapitulációról.

A deepfake of Ukrainian President Volodymyr Zelensky calling on his soldiers to lay down their weapons was reportedly uploaded to a hacked Ukrainian news website today, per @Shayan86 pic.twitter.com/tXLrYECGY4

— Mikael Thalen (@MikaelThalen) March 16, 2022

De készült ilyen Putyinról is:

Президент РФ обьявил о капитуляции россии. Русский солдат, бросай оружие и иди домой, пока жив! pic.twitter.com/5wWC3UlpYr

— Serhii Sternenko (@sternenko) March 16, 2022

Sőt, olyan is, amelyen Putyin magyarul szaval verset:

Deepfake videókat már használtak is politikai kampányok során, bár egyelőre olyan kirívó esetek nem láttak napvilágot, amelyek bizonyítottan befolyásolták volna egy választás eredményét. Indiában 2020-ban a kormányzó párt (BJP) elnöke, Manoj Tiwari használt deepfake-et arra, hogy az általa nem használt nyelveken és dialektusokban is meg tudja szólítani a választópolgárokat. (Tiwari eredeileg bhódzspuri nyelven kritizálta az egyik politikai ellenfelét, ezt több mint 20 különböző dialektusra fordították le úgy, hogy a szájmozgása is illeszkedjen a beszédhez, így ért el 15 millió potenciális szavazót.)

Az amerikai elnökválasztási kampányban pedig a RepresentUs nevű korrupcióellenes szervezet kezdeményezésére készítettek deepfake videókat Vlagyimir Putyin orosz elnökről és Kim Dzsongun észak-koreai vezetőről. A kampányt azzal a céllal tervezték, hogy felhívják az amerikaiak figyelméta demokrácia törényekségére, végül azonban a Fox, a CNN, és az MSNBC is visszalépett a hirdetések sugárzásától.

Míg a face swap vagy a deepfake alkalmazások létező személyek identitásával élnek vissza, addig az olyan programok mint a ThisPersonDoesn’t Exist a semmiből alkotnak új perszónákat. (A semmit természetesen nem szó szerint kell érteni, az AI a betanítás során betáplált milliónyi képből alkotja meg az ilyen összeállításban nem létező arcokat). Az arcgeneráló programmal lehet ma a legkönnyebben hamis közösségi média profilokat létrehozni, köszönhetően annak, hogy a program egy kattintásra magas minőségű, a megtévesztésig hiteles arcképeket generál ki. Így születtek meg azok az “újságírói” profilok is február végén, amelyek lejárató üzeneteket terjesztettek az ukrán vezetésről – egy orosz dezinformációs művelet részeként.

Vladimir’s coworker Irina Kerimova from Kharkiv was also AI-generated.

— Ben Collins (@oneunderscore__) February 28, 2022

She was a private guitar teacher (?) until she became editor-in-chief of this Russian propaganda website in 2017. Quite a promotion!

Also, interesting choice of mismatched earrings. pic.twitter.com/lor2gVsV4M

Ha lehet, még ennél is tovább ment az OpenAI DALL-E projektje, amely pusztán szövegek betáplálásával képes képeket kreálni. “A következő fényképhez például, amelyen orosz katonák vonják fel az ukrán zászlót Kijev szívében, elég volt pár kulcsszót megadni” – magyarázta Shirin Anlen médiatechnológus a GlobalFact9 konferencián tartott, deepfake-ről szóló workshopján.

A két képet a DALL-E program az “orosz katonák felhúznak egy ukrán zászlót Kijevben, fénykép, 8k” szövegek betáplálásával állította elő. Forrás: GlobalFact9

A manipulált képek és videók már ma is nagy számban keringenek az online térben, ez a trend pedig a jövőben valószínűleg csak erősödni fog. Az eredményes védekezéshez jó kiindulópont lehet, ha először is magunkban tudatosítjuk, hogy nem minden kép vagy arc valódi, csak mert (foto)realisztikus. Gyakorlásképp érdemes ellátogatni a Which Face is Real? oldalára, ahol két profilkép közül kell eldönteni, melyik az igazi.

A képek valódiságának felismeréséhez ma még mankót nyújtanak azok a hibák, amelyek időnként becsúsznak az algoritmus munkájába. A leggyakoribb gliccsek a női portrék esetében a nem passzoló fülbevalók, de a furcsán illeszkedő szemüvegszárak vagy a nem odavaló tárgyak is megkongathatják a fejünkben a vészharangot.

Hibás részletek a ThisPersonDoesntExist oldalon generált portrékon

Ezek a hibák idővel el fognak tűnni, ahogy a technológia fejlődik. Ha a szemünkben már nem bízunk, még mindig fordulhatunk olyan programokhoz, amelyek jeleznek, ha deepfake-kel van dolgunk – ilyen alkalmazás például a Deepware, vagy a V7 Lab új Chrome kiterjesztése, amely az AI által generált profilképeket szűri ki.

V7 fejlesztői azt állítják, hogy a program 99,28%-os pontossággal dolgozik, azonban nem lehet teljességgel kizárni a tévedés lehetőségét (lásd az alábbi kép).

Egy DALL-E programmal generált portré, amely átment a V7 értékelésén.

“A jelenleg elérhető technológiai megoldásoknak a legnagyobb hátulütője, hogy nem indokolják meg, mi alapján mondják valamire, hogy »igaz« vagy »hamis«, ez pedig kiteszi az újságírókat, tényellenőröket vagy a hétköznapi felhasználókat annak, hogy vakon bízzanak a kapott eredményben – mondta Shirin Anlen a Global Facts 9 konferencián.

Ráadásul, ahogy egyre jobb (értsd valósághűbb) deepfake-k születnek, úgy terjed ki a gyanakvásunk a valódi felvételekre. Nagy port kavart például tavaly nyáron az a videó, amelyen az egykori mianmari főminiszter fogalmazott meg súlyos vádakat a burmai vezetéssel szemben. Bár Phyo Min Theint politikai fogolyként tartják fogva a mianmari fegyveres erők, sokan mégis úgy gondolták, hogy a videó deepfake, ezt pedig a legtöbb detektáló program is megerősítette. A felvételen a politikus hangja eltér a megszokottól, a testtartása is természetellenes, ennek oka azonban, mint utólag kiderült, hogy a videó kényszerítés hatására készült. Az alacsony felbontású képsorok esetében ráadásul a felismerőprogramok teljesítménye jelentősen gyengébb - mivel általában magas felbontású képeken trenírozzák őket.

Shirin Anlen macska-egér játékként jellemezte a kialakult helyzetet: egyre profibb képgeneráló programok születnek, ezekre válaszul a képfelismerő rendszerek is egyre jobbak lesznek, majd ezek kijátszására kezdődik az egész előlről.

2021 tavaszán a Budapesti Corvinus Egyetemen működő CGI-Deepfake kutatócsoport egy nagy (10 730 főből álló) kitöltőszámot elért kérdőíves felmérést végzett, amelynek a célja az volt, hogy felderítsék, az interneten található megtévesztő szándékú tartalmak hogyan hatnak a befogadókra. A kutatásból kiderült többek közt az is, hogy a felhasználók döntő többségét a deepfake technológia használata során főként a szórakozási lehetőség és a kíváncsiság motiválja, és elhanyagolható azok aránya, akik valakinek ártani akarnak a manipulált tartalmak közzétételével.

Dr. Veszelszki Ágnes, a kutatócsoport vezetője kiemelte: a kérdőív kitöltői a különféle deepfake-videók létrehozásakor főként saját arcukat használták fel behelyettesítőként, ezt követik a barátok, rokonok, majd a híres emberek, és alig fordult elő a kitöltők közt olyan, akiaki olyan személy arcát választotta, akit nem kedvel. A kutatásban mindössze 4-en állították (0,039 százalék, hogy bosszúból vagy haragból készítettek deepfake-videót.

A szórakoztató tartalmak esetében nincs is probléma, amíg mindenki tisztában van vele, hogy nem a valóságot látja: egyesek már a filmgyártás jövőjét is megalapoznák a technológiával. Van, aki szerint például nem sikerült túl jól Leia hercegnő feltámasztása a Zsivány Egyes – Egy Star Wars-történet végén, így megalkotta a saját verzióját a deepfake technológia segítségével.

A dél-koreai MBN csatorna például egyik hírolvasója, Kim Joo-Ha deepfake verzióját “ültette le” híreket olvasni. A csatorna előre figyelmeztette nézőit, hogy akit látnak, az nem a létező bemondó, hanem csupán mesterséges intelligenciával előállított mása, ám azt is jelezték, hogy a jövőben terveznek hasonló adásokat, amikor például rendkívüli események közvetítéséhez kell hirtelen adást készíteniük.

Azonban a deepfake technológiával készült tartalmak sok szempontból lehetnek aggályosak, (gondoljunk csak a bosszúpornóra vagy anyagi haszonszerzésből történő csalásokra). Nem csoda, hogy a technológiában rejlő veszélyeket felismerve több platform (például a Twitter, vagy a deepfake bölcsője, a Reddit) és az egyik legismertepp pornómegosztó csatorna, a PornHub is hamar lépett, és kitiltotta az oldaláról az ilyen típusú tartalmakat. Jelenleg azonban a deepfake szürkezónában működik: a manipulált tartalmakat kiszűrő szoftverek korántsem működnek tökéletesen, és sok esetben a rájuk vonatkozó jogi szabályozás sem egyértelmű.

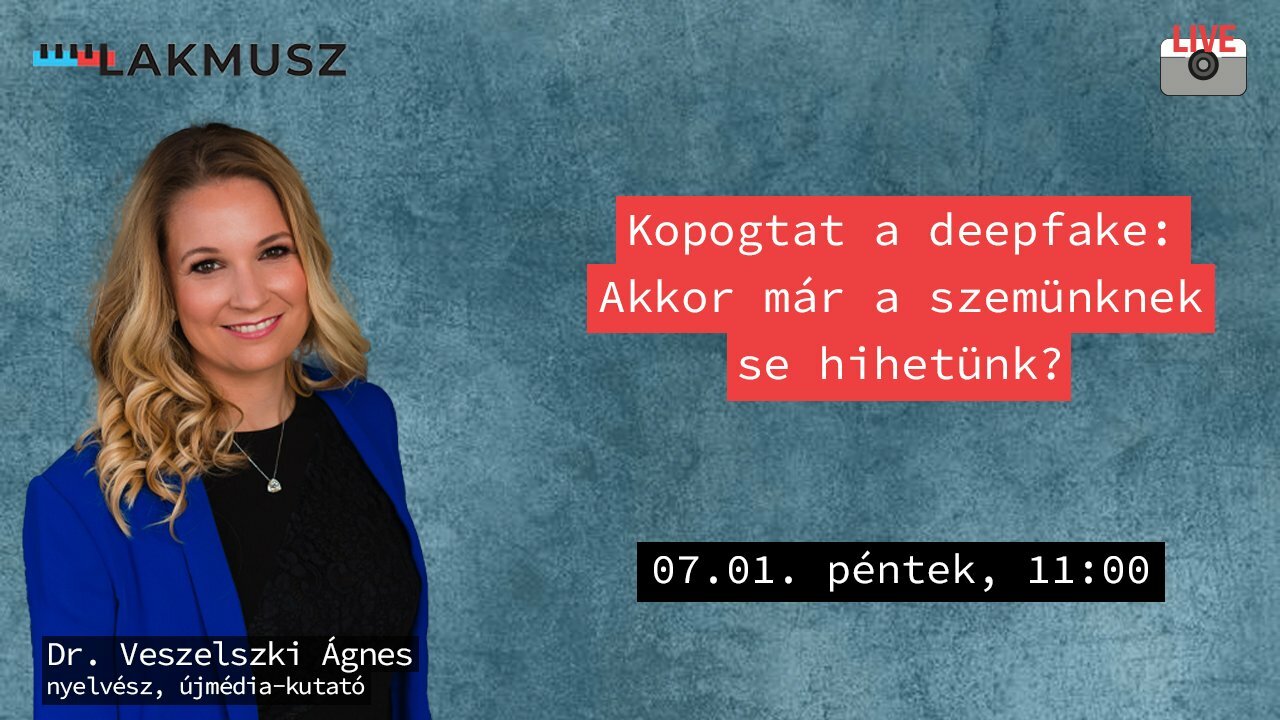

Július elsején (pénteken) 11 órától a Lakmusz Facebook-oldalán Dr. Veszelszki Ágnessel beszélgetünk a deepfake jelenéről és jövőjéről, a technológia pozitív és negatív felhasználási módjairól, a szabályozás nehézségeiről, és arról, hogy ha már a szemünknek sem hihetünk, mi lesz a sajtóba vetett bizalommal. Már a beszélgetés előtt és az élő esemény idején is küldhettek nekünk kérdéseket Facebook-kommentben, igyekszünk majd megválaszolni ezeket a beszélgetég során.

Illusztráció: Deep Fake Tube